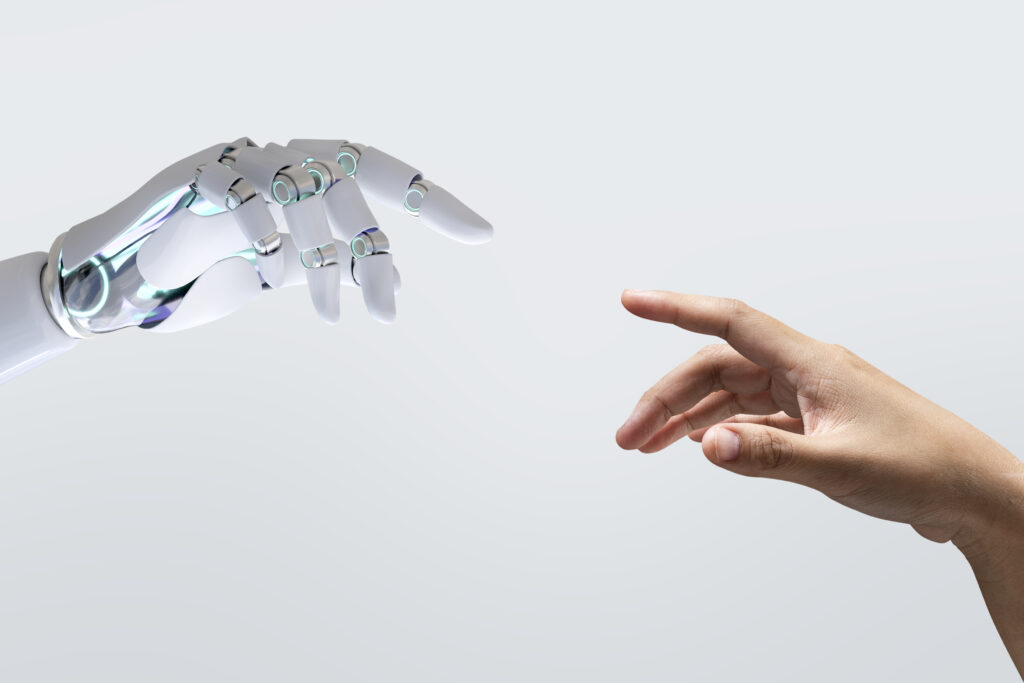

A adoção da inteligência artificial (IA) está revolucionando indústrias inteiras, desde a automação de processos empresariais até avanços em cuidados de saúde personalizados. No entanto, à medida que aceleramos o ritmo da inovação tecnológica, é crucial que as empresas e líderes reconheçam e enfrentem os desafios éticos que emergem nesse cenário.

Oportunidades e riscos éticos

O grande potencial da IA está em sua capacidade de processar grandes volumes de dados, gerar insights preditivos e automatizar tarefas com eficiência. No entanto, essa tecnologia não é neutra. Cada algoritmo desenvolvido carrega as decisões, valores e, muitas vezes, vieses de seus programadores. Isso levanta questões profundas sobre responsabilidade corporativa, transparência e impacto social.

Principais desafios:

- Vieses algorítmicos:

O viés algorítmico ocorre quando os sistemas de IA tomam decisões que favorecem certos grupos em detrimento de outros, refletindo desigualdades históricas ou falhas no design do modelo. Um exemplo bem documentado é o uso da IA em recrutamento, onde certos algoritmos favoreceram candidatos homens por conta de padrões anteriores nos dados. Empresas precisam investir em ferramentas de auditoria para identificar e mitigar esses vieses de forma contínua, garantindo uma tomada de decisão justa e imparcial. - Privacidade de dados:

A coleta massiva de dados é a base do aprendizado de máquina, mas isso coloca a privacidade em risco. As regulamentações como a GDPR na Europa e a LGPD no Brasil pressionam as empresas a garantir que os dados sejam usados de forma responsável e que os usuários tenham controle sobre suas informações. A negligência nessa área pode não apenas resultar em sanções legais, mas também em danos reputacionais graves. - Transparência e explicabilidade:

Para que as empresas mantenham a confiança de seus stakeholders, é essencial que suas soluções de IA sejam explicáveis. Modelos de IA, especialmente os baseados em deep learning, podem ser difíceis de interpretar até mesmo por especialistas. A transparência vai além da explicabilidade técnica: envolve também uma comunicação clara sobre como e por que determinadas decisões são tomadas, como, por exemplo, decisões de crédito ou recomendações de saúde.

Diretrizes para uma implementação ética da IA

A implementação ética da IA requer uma abordagem multifacetada, que envolva não apenas compliance com normas regulatórias, mas também um compromisso com a responsabilidade social e governança corporativa robusta. Abaixo, destaco algumas diretrizes estratégicas:

- Desenvolvimento de políticas de IA responsável:

As empresas devem criar políticas específicas que definam os limites éticos da IA, incluindo diretrizes claras sobre como mitigar vieses, proteger dados e garantir transparência. Isso pode ser complementado por um comitê ético que atue como uma força moderadora na adoção de novas tecnologias. - Governança e auditoria de algoritmos:

Estabelecer uma governança sólida para os algoritmos é fundamental. Isso inclui a realização de auditorias frequentes para monitorar como os sistemas de IA estão operando na prática. Um exemplo é o conceito de “IA explicável”, em que as empresas devem ser capazes de justificar as decisões de seus algoritmos de forma compreensível para qualquer stakeholder. - Inclusão e diversidade no desenvolvimento de IA:

O desenvolvimento de IA deve ser inclusivo, incorporando vozes diversas desde o design até a implementação. Modelos treinados com dados que refletem uma diversidade de experiências e realidades são menos propensos a apresentar vieses prejudiciais.

Empresas líderes na ética da IA

Algumas organizações já estão liderando pelo exemplo na incorporação da ética à IA.

- Google: A empresa vem desenvolvendo iniciativas focadas em IA explicável e em ferramentas que ajudam a detectar e corrigir vieses. Eles também publicaram princípios éticos para guiar o desenvolvimento de suas tecnologias, um passo importante para a transparência.

- Microsoft: Tem sido uma pioneira no desenvolvimento de ferramentas que promovem uma IA mais inclusiva. Sua ferramenta AI Fairness Checklist ajuda a auditar sistemas para garantir que as soluções tecnológicas não discriminem certos grupos. Além disso, a Microsoft tem investido em programas de educação para promover uma adoção mais ética e responsável da IA.

O papel da governança corporativa

A governança da IA não pode ser tratada de forma isolada. Deve estar integrada à governança corporativa como um todo, com os conselhos de administração e comitês de auditoria assumindo um papel ativo na supervisão das tecnologias emergentes. A transparência, a responsabilidade e o alinhamento com os valores organizacionais são essenciais para assegurar que a IA seja usada de forma a maximizar o impacto positivo e mitigar riscos éticos.

O futuro da IA: inovação sustentável

Em última análise, o futuro da IA dependerá da capacidade das organizações de equilibrar inovação com responsabilidade. As empresas que conseguirem promover esse equilíbrio serão aquelas que garantirão não apenas o sucesso financeiro a longo prazo, mas também a confiança e a lealdade de seus clientes, colaboradores e parceiros.

A verdadeira inovação tecnológica está intrinsicamente ligada à responsabilidade ética.

A IA pode transformar o mundo, mas cabe a nós, líderes empresariais, moldar essa transformação de maneira inclusiva, justa e transparente. 🌐

Para ler mais sobre Governança Corporativa (clique aqui)

Assine a Newsletter no LinkedIn